HISTORIA DEL COMPUTADOR

La primera máquina de calcular mecánica, un precursor del computador

digital, fue inventada en 1642 por el matemático francés Blaise Pascal.

Aquel dispositivo utilizaba una serie de ruedas de diez dientes en las

que cada uno de los dientes representaba un dígito del 0 al 9. Las

ruedas estaban conectadas de tal manera que podían sumarse números

haciéndolas avanzar el número de dientes correcto. En 1670 el filósofo y

matemático alemán Gottfried Wilhelm Leibniz perfeccionó esta máquina e

inventó una que también podía multiplicar.

El inventor francés Joseph Marie Jacquard, al diseñar un telar automático, utilizó delgadas placas de madera perforadas para controlar el tejido utilizado en los diseños complejos. Durante la década de 1880 el estadístico estadounidense Herman Hollerith concibió la idea de utilizar tarjetas perforadas, similares a las placas de Jacquard, para procesar datos. Hollerith consiguió compilar la información estadística destinada al censo de población de 1890 de Estados Unidos mediante la utilización de un sistema que hacía pasar tarjetas perforadas sobre contactos eléctricos.

La máquina analítica

La tecnología de aquella época no era capaz de trasladar a la

práctica sus acertados conceptos; pero una de sus invenciones, la

máquina analítica, ya tenía muchas de las características de un

computador moderno. Incluía una corriente, o flujo de entrada en forma

de paquete de tarjetas perforadas, una memoria para guardar los datos,

un procesador para las operaciones matemáticas y una impresora para

hacer permanente el registro.

Primeros computadores

Los computadores analógicos comenzaron a construirse a principios del siglo XX. Los primeros modelos realizaban los cálculos mediante ejes y engranajes giratorios. Con estas máquinas se evaluaban las aproximaciones numéricas de ecuaciones demasiado difíciles como para poder ser resueltas mediante otros métodos. Durante las dos guerras mundiales se utilizaron sistemas informáticos analógicos, primero mecánicos y más tarde eléctricos, para predecir la trayectoria de los torpedos en los submarinos y para el manejo a distancia de las bombas en la aviación.

Computadores electrónicos

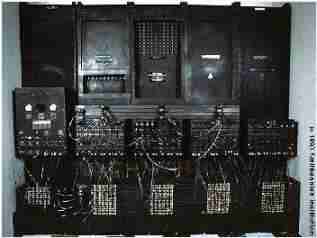

Durante la II Guerra Mundial (1939-1945), un equipo de científicos y matemáticos que trabajaban en Bletchley Park, al norte de Londres, crearon lo que se consideró el primer computador digital totalmente electrónico: el Colossus.

Hacia diciembre de 1943 el Colossus, que incorporaba 1.500 válvulas o

tubos de vacío, era ya operativo. Fue utilizado por el equipo dirigido

por Alan Turing para descodificar los mensajes de radio cifrados de los

alemanes.

En 1939 y con independencia de este proyecto, John Atanasoff y

Clifford Berry ya habían construido un prototipo de máquina electrónica

en el Iowa State College (EEUU). Este prototipo y las investigaciones

posteriores se realizaron en el anonimato, y más tarde quedaron

eclipsadas por el desarrollo del Calculador e integrador numérico

digital electrónico (ENIAC) en 1945. El ENIAC, que según mostró la

evidencia se basaba en gran medida en el ‘computador’ Atanasoff-Berry

(ABC, acrónimo de Electronic Numerical Integrator and Computer), obtuvo

una patente que caducó en 1973, varias décadas más tarde.

El ENIAC contenía 18.000 válvulas de vacío y tenía una velocidad de

varios cientos de multiplicaciones por minuto, pero su programa estaba

conectado al procesador y debía ser modificado manualmente. Se construyó

un sucesor del ENIAC con un almacenamiento de programa que estaba

basado en los conceptos del matemático húngaro-estadounidense John von

Neumann. Las instrucciones se almacenaban dentro de una llamada memoria,

lo que liberaba al ordenador de las limitaciones de velocidad del

lector de cinta de papel durante la ejecución y permitía resolver

problemas sin necesidad de volver a conectarse al ordenador.

A finales de la década de 1950 el uso del transistor en los

ordenadores marcó el advenimiento de elementos lógicos más pequeños,

rápidos y versátiles de lo que permitían las máquinas con válvulas. Como

los transistores utilizan mucha menos energía y tienen una vida útil

más prolongada, a su desarrollo se debió el nacimiento de máquinas más

perfeccionadas, que fueron llamadas ordenadores o computadoras de

segunda generación. Los componentes se hicieron más pequeños, así como

los espacios entre ellos, por lo que la fabricación del sistema

resultaba más barata.

Circuitos integrados

A finales de la década de 1960 apareció el circuito integrado (CI), que posibilitó la fabricación de varios transistores en un único sustrato de silicio en el que los cables de interconexión iban soldados. El circuito integrado permitió una posterior reducción del precio, el tamaño y los porcentajes de error. El microprocesador se convirtió en una realidad a mediados de la década de 1970, con la introducción del circuito de integración a gran escala (LSI, acrónimo de Large Scale Integrated) y, más tarde, con el circuito de integración a mayor escala (VLSI, acrónimo de Very Large Scale Integrated), con varios miles de transistores interconectados soldados sobre un único sustrato de silicio.

- Las primeras máquinas

En el siglo XVII el famoso matemático escocés John

Napier, distinguido por la invención de los logaritmos, desarrolló un

ingenioso dispositivo mecánico que utilizando unos palitos con números

impresos permitía realizar operaciones de multiplicación y división.

En

1642, el matemático francés Blaise Pascal construyó la primera

calculadora mecánica. Utilizando una serie de piñones, la calculadora de

Pascal sumaba y restaba.

En

1642, el matemático francés Blaise Pascal construyó la primera

calculadora mecánica. Utilizando una serie de piñones, la calculadora de

Pascal sumaba y restaba.

A finales del siglo XVII el alemán Gottfried Von

Leibnitz perfeccionó la máquina de Pascal al construir una calculadora

que mecánicamente multiplicaba, dividía y sacaba raíz cuadrada. Propuso

desde aquella época una máquina calculadora que utilizara el sistema

binario.

A mediados del siglo XIX, el profesor inglés Charles

Babbage diseñó su "Máquina Analítica" e inclusive construyó un pequeño

modelo de ella. La tragedia histórica radica en que no pudo elaborar la

máquina porque la construcción de las piezas era de precisión muy

exigente para la tecnología de la época. Babbage se adelantó casi un

siglo a los acontecimientos. Su Máquina Analítica debía tener una

entrada de datos por medio de tarjetas perforadas, un almacén para

conservar los datos, una unidad aritmética y la unidad de salida.

Desde la muerte de Babbage, en 1871, fue muy lento el

progreso. Se desarrollaron las calculadoras mecánicas y las tarjetas

perforadas por Joseph Marie Jacquard para utilizar en los telares,

posteriormente Hollerith las utilizó para la "máquina censadora", pero

fue en 1944 cuando se dio un paso firme hacia el computador de hoy.

- La Era Electrónica

En la Universidad de Harvard, en 1944, un equipo

dirigido por el profesor Howard Aiken y patrocinado por la IBM construyó

la Mark I, primera calculadora automática. En lugar de usar piñones

mecánicos, Mark I era un computador electromecánico: utilizaba

relevadores electromagnéticos y contadores mecánicos.

Sólo

dos años más tarde, en 1946, se construyó en la Escuela Moore, dirigida

por Mauchly y financiada por el Ejército de los Estados Unidos, la

ENIAC (Electronic Numerical Integrator and Calculator), la cual podía

ejecutar multiplicaciones en 3 milésimas de segundo (Mark I tardaba 3

segundos). Sin embargo, las instrucciones de ENIAC debían ser dadas por

medio de una combinación de contactos externos, ya que no tenía cómo

almacenarlas internamente.

Sólo

dos años más tarde, en 1946, se construyó en la Escuela Moore, dirigida

por Mauchly y financiada por el Ejército de los Estados Unidos, la

ENIAC (Electronic Numerical Integrator and Calculator), la cual podía

ejecutar multiplicaciones en 3 milésimas de segundo (Mark I tardaba 3

segundos). Sin embargo, las instrucciones de ENIAC debían ser dadas por

medio de una combinación de contactos externos, ya que no tenía cómo

almacenarlas internamente.

A mediados de los años 40 el matemático de Princeton

John Von Neumann diseñó las bases para un programa almacenable por medio

de codificaciones electrónicas. Esta capacidad de almacenar

instrucciones es un factor definitivo que separa la calculadora del

computador. Además propuso la aritmética binaria codificada, lo que

significaba sencillez en el diseño de los circuitos para realizar este

trabajo. Simultáneamente se construyeron dos computadores: el EDVAC

(Electronic Discrete Variable Automatic Computer) y en 1949 en la

Universidad de Cambridge el EDSAC (Electronic Delay Storage Automatic

Computer), que fue realmente la primera computadora electrónica con

programa almacenado.

En 1951 John W. Mauchly y J. Presper Eckert Jr.

construyen el UNIVAC I, el primer computador para el tratamiento de

información comercial y contable. UNIVAC (Universal Automatic Computer)

reemplazó el objetivo de sus antecesoras que era científico y militar,

abriendo paso a la comercialización de los computadores; aquí se inician

las generaciones de computadores.

- Las Generaciones de los Computadores

A partir de ese momento, la evolución de los

computadores ha sido realmente sorprendente. El objetivo inicial fue el

de construir equipos más rápidos, más exactos, más pequeños y más

económicos. Este desarrollo se ha clasificado por "generaciones de

computadores", así:

Primera generación de computadores 1950 - 1958

En esta generación nace la industria de los

computadores. El trabajo del ENIAC, del EDVAC, del EDSAC y demás

computadores desarrollados en la década de los 40 había sido básicamente

experimental.  Se habían utilizado con fines científicos pero era evidente que su uso podía desarrollarse en muchas áreas.

Se habían utilizado con fines científicos pero era evidente que su uso podía desarrollarse en muchas áreas.

Se habían utilizado con fines científicos pero era evidente que su uso podía desarrollarse en muchas áreas.

Se habían utilizado con fines científicos pero era evidente que su uso podía desarrollarse en muchas áreas.

La primera generación es la de los tubos al vacío.

Eran máquinas muy grandes y pesadas con muchas limitaciones. El tubo al

vacío es un elemento que presenta gran consumo de energía, poca duración

y disipación de mucho calor. Era necesario resolver estos problemas.

UNIVAC I fue adquirido por el Census Bureau de los

Estados Unidos para realizar el censo de 1951. IBM perdió este contrato

porque sus máquinas de tarjetas perforadas fueron desplazadas por el

computador. Fue desde ese momento que la IBM empezó a ser una fuerza

activa en la industria de los computadores.

En 1953 IBM lanzó su computador IBM 650, una máquina

mediana para aplicaciones comerciales. Inicialmente pensó fabricar 50,

pero el éxito de la máquina los llevó a vender más de mil unidades.

Segunda generación 1959 - 1964

En 1947 tres científicos: W. Shockley, J. Bardeen y

H.W. Brattain, trabajando en los laboratorios Bell, recibieron el premio

Nobel por inventar el transistor. Este invento nos lleva a la segunda

generación de computadores. El transistor es mucho más pequeño que el

tubo al vacío, consume menos energía y genera poco calor.

La utilización del transistor en la industria de la

computación conduce a grandes cambios y una notable reducción de tamaño y

peso.

En esta generación aumenta la capacidad de memoria,

se agilizan los medios de entrada y salida, aumentan la velocidad y

programación de alto nivel como el Cobol y el Fortran.

Entre los principales fabricantes se encontraban IBM,

Sperry - Rand, Burroughs, General Electric, Control Data y Honeywell.

Se estima que en esta generación el número de computadores en los

Estados Unidos pasó de 2.500 a 18.000.

Tercera generación 1965 - 1971

El cambio de generación se presenta con la

fabricación de un nuevo componente electrónico: el circuito integrado.

Incorporado inicialmente por IBM, que lo bautizó SLT (Solid Logic

Technology). Esta tecnología permitía almacenar los componentes

electrónicos que hacen un circuito en pequeñas pastillas, que contienen

gran cantidad de transistores y otros componentes discretos.

Abril

7 de 1964 es una de las fechas importantes en la historia de la

computación. IBM presentó el sistema IBM System/360, el cual consistía

en una familia de 6 computadores, compatibles entre sí, con 40

diferentes unidades periféricas de entrada, salida y almacenaje. Este

sistema fue el primero de la tercera generación de computadores. Su

tecnología de circuitos integrados era mucho más confiable que la

anterior, mejoró además la velocidad de procesamiento y permitió la

fabricación masiva de estos componentes a bajos costos.

Abril

7 de 1964 es una de las fechas importantes en la historia de la

computación. IBM presentó el sistema IBM System/360, el cual consistía

en una familia de 6 computadores, compatibles entre sí, con 40

diferentes unidades periféricas de entrada, salida y almacenaje. Este

sistema fue el primero de la tercera generación de computadores. Su

tecnología de circuitos integrados era mucho más confiable que la

anterior, mejoró además la velocidad de procesamiento y permitió la

fabricación masiva de estos componentes a bajos costos.

Otro factor de importancia que surge en esta tercera

generación es el sistema de procesamiento multiusuario. En 1964 el

doctor John Kemeny, profesor de matemáticas del Darmouth College,

desarrolló un software para procesamiento multiusuario. El sistema Time

Sharing (tiempo compartido) convirtió el procesamiento de datos en una

actividad interactiva. El doctor Kemeny también desarrolló un lenguaje

de tercera generación llamado BASIC.

Como consecuencia de estos desarrollos nace la

industria del software y surgen los minicomputadores y los terminales

remotos, aparecen las memorias electrónicas basadas en semiconductores

con mayor capacidad de almacenamiento.

Cuarta generación 1972 - ?

Después de los cambios tan específicos y marcados de

las generaciones anteriores, los desarrollos tecnológicos posteriores, a

pesar de haber sido muy significativos, no son tan claramente

identificables.

En la década del 70 empieza a utilizarse la técnica

LSI (Large Scale Integration) Integración a Gran Escala. Si en 1965 en

un "chip" cuadrado de aproximadamente 0.5 centímetros de lado podía

almacenarse hasta 1.000 elementos de un circuito, en 1970 con la técnica

LSI podía almacenarse 150.000.

Algunos investigadores opinan que esta generación se inicia con la introducción del sistema IBM System/370 basado en LSI.

Otros dicen que la microtecnología es en realidad el

factor determinante de esta cuarta generación. En 1971 se logra

implementar en un chip todos los componentes de la Unidad Central de

Procesamiento fabricándose así un microprocesador, el cual a vez dio

origen a los microcomputadores.

Algunas características de esta generación de

microelectrónica y microcomputadores son también: incremento notable en

la velocidad de procesamiento y en las memorias; reducción de tamaño,

diseño modular y compatibilidad entre diferentes marcas; amplio

desarrollo del uso del minicomputador; fabricación de software

especializado para muchas áreas y desarrollo masivo del microcomputador y

los computadores domésticos.

Partes Del Computador

MONITOR

El monitor es la pantalla en la que se ve la información suministrada por elordenador. En el caso más habitual se trata de un aparato basado en untubo de rayos catódicos (CRT) como el de los televisores, mientras que enlos portátiles y los monitores nuevos, es una pantalla plana de cristal líquid

CPU

Aunque muchas de las veces nos han indicado que es el CPU, aún se

sigue mal interpretando a dicho término asignandolo a otro tipo de

características que en realidad, no es la adecuada.

En sí, el CPU es la definición de la Central Processing Unit (ó mejor dicho Unidad Central de Procesos), mismo que está encargado de de gestionar cada una de las ordenes que se emiten para las aplicaciones como para los dispositivos, mismos que actúan en base a software debido a la presencia de sus controladores, una forma de hardware.

En sí, el CPU es la definición de la Central Processing Unit (ó mejor dicho Unidad Central de Procesos), mismo que está encargado de de gestionar cada una de las ordenes que se emiten para las aplicaciones como para los dispositivos, mismos que actúan en base a software debido a la presencia de sus controladores, una forma de hardware.

TECLADO

Un teclado es un periférico de entrada que permite introducir órdenes y/o datos a la computadora o dispositivo digital. El

teclado se conecta al computador por medio de un puerto serial o al

USB. Básicamente el teclado esta compuesto por un grupo de teclas,

similares a las de una máquina de escribir, correspondiendo cada tecla a

uno o varios caracteres, funciones u órdenes.

MOUSE

,

El mouse o ratón es un dispositivo pequeño que permite señalar e

engresar información. Se le denomina raton debido a su apariencia. Un

mouse regularmente es arrastrado sobre una superficie plana (escritorio o

mesa) el movimiento realizado por el mouse es reflejada dentro del

monitor mediante una flechita llamada puntero del mouse. La acción de

pulsar y soltar un botón se denomina clic.

ALTAVOZ

Un

altavoz es un transductor electroacústico, es decir, convierte energía

eléctrica en energía acústica. Esta conversión tiene lugar en dos

etapas: la señal eléctrica produce el movimiento del diafragma del

altavoz y este movimiento produce a su vez ondas de presión (sonido) en

el aire que rodea al altavoz.

AURICULARES

Los auriculares son transductores que reciben una señal eléctrica de un tocador de medios de comunicación o el receptor y usan altavoces colocados en la proximidad cercana a los oídos para convertir la señal en ondas sonoras audibles.

WEBCAM

Una webcam es una cámara de video pequeña que funciona

conectada a un computador. La webcam captura imágenes para luego transmitirlas a

través de Internet a una o más personas. La webcam puede ser utilizada tanto por

páginas web, como por personas a través de sus computadores. Es mayormente

utilizada en servicios de mensajería instantánea en donde se pueden mandar

videos en vivo o grabados previamente. La webcam es uno de los dispositivos más

populares en todo el mundo.

IMPRESORA

Una impresora es un periférico de ordenador

que permite producir una copia permanente de textos o gráficos de

documentos almacenados en formato electrónico, imprimiéndolos en medios

físicos, normalmente en papel o transparencias, utilizando cartuchos de tinta o tecnología láser.

MODEM

|

Módem es un acrónimo de MOdulador-DEModulador; es decir, que es un

dispositivo que transforma las señales digitales del ordenador en señal

telefónica analógica y viceversa, con lo que permite al ordenador

transmitir y recibir información por la línea telefónica.

Los chips que realizan estas funciones están casi tan estandarizados

como los de las tarjetas de sonido; muchos fabricantes usan los mismos

integrados, por ejemplo de la empresa Rockwell, y sólo se diferencian

por los demás elementos electrónicos o la carcasa.

|

No hay comentarios:

Publicar un comentario